Contexto e Desafio

O módulo de Perguntas Manuais faz parte de uma plataforma de gestão de vendas em Marketplaces e automatiza respostas para anúncios do Mercado Livre. Porém, em muitos casos, era necessário escrever respostas personalizadas manualmente — o que gerava lentidão, retrabalho e risco de sair do tom de voz esperado.

Além disso, a plataforma apresentava problemas sérios de usabilidade: usuários perdiam tempo tentando entender como usar o sistema e, com isso, acabavam desistindo do serviço.

O desafio foi criar um redesign completo do módulo, tornando a interface mais objetiva, funcional e alinhada ao fluxo real de trabalho. O foco era permitir respostas manuais rápidas e eficientes, sem comprometer a lógica da automação.

Minha função: liderei o projeto de UX, conduzi entrevistas com usuários, defini fluxos e interfaces, e validei a solução junto ao time e stakeholders.

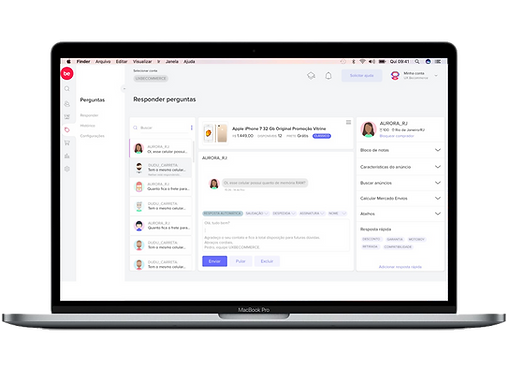

Esse é o módulo antes

da nova proposta!

1

Imersão e Descoberta (Empatia)

Foram realizadas entrevistas com operadores e shadowing de suas atividades diárias para entender como o módulo de respostas era utilizado na prática. Também foram considerados insumos anteriores, que já haviam identificado dois perfis principais de usuários: o dono da conta e o operador.

Em contas grandes, é comum que existam operadores dedicados exclusivamente a responder perguntas nos anúncios — uma tarefa crítica, já que o tempo de resposta inferior a 1 hora é um fator que influencia diretamente a Reputação do vendedor no Mercado Livre. Essa reputação funciona como um termômetro de performance, impactando a visibilidade e a confiabilidade da loja.

Entre as principais descobertas, estavam:

-

O processo de resposta manual era feito fora da ferramenta principal, gerando inconsistência e retrabalho.

-

Havia insegurança sobre quem já havia respondido o quê, o que causava duplicidade ou ausência de resposta.

-

Os usuários sentiam falta de histórico, versionamento e confirmação de envio, o que dificultava o controle e a rastreabilidade da operação.

“Às vezes eu começo a responder, mas não sei se outra pessoa já está fazendo isso.” — operador da plataforma

2

Definição do Problema (Definir)

Reenquadramento do desafio: “Como podemos permitir que os sellers escrevam e enviem respostas manuais dentro da plataforma, mantendo rastreabilidade e consistência?”

-

HMW (How Might We...): Como podemos permitir respostas humanas sob demanda, sem quebrar o fluxo automatizado?

-

Critérios de sucesso:

-

Redução de tempo médio por resposta.

-

Aumento na confiança da equipe em relação ao sistema.

-

Rastreabilidade de todas as mensagens manuais.

-

3

Ideação

Durante essa etapa, usamos um Task Flow para mapear o caminho que o operador percorre ao responder uma pergunta, detalhando cada etapa da jornada e o inventário de ações envolvidas. Esse exercício ajudou a visualizar os pontos de atrito com mais clareza e levantar melhorias viáveis.

Com esse material em mãos, realizamos sessões de brainstorming com o time de produto e engenharia para explorar soluções que equilibrassem agilidade, controle e clareza de uso.

Exploração de soluções:

-

Criação de um botão “Responder manualmente” direto na interface do evento.

-

Campo de resposta com validação, contador de caracteres e histórico de edições.

-

Notificação visual para evitar duplicidade de respostas.

-

Construção de wireframes low-fi no Figma para simular o novo fluxo e validar a proposta com rapidez.

4

Prototipação

Nível de fidelidade: Alta — o protótipo já simulava resposta manual, histórico e edição.

-

Ferramentas utilizadas: Figma.

-

Testamos:

-

Fluidez do fluxo de escrita.

-

Clareza sobre quem escreveu o quê.

-

Confirmação de envio e arquivamento.

-

5

Testes com Usuários (Validação)

Roteiro e metodologia: Teste moderado com 5 operadores que usariam a funcionalidade.

O que aprendi:

-

A visualização do histórico era essencial.

-

Precisávamos mostrar um alerta claro se uma resposta já tivesse sido enviada.

Solução Final

Interfaces e fluxos entregues:

-

Tela de evento com botão “Responder manualmente”.

-

Campo de texto com contador de caracteres e histórico de respostas.

-

Registro de autor, data e versão.

-

Racional de design:

-

Simples, sem atrito, mas com rastreabilidade clara.

-

Reforça o controle humano dentro de um sistema automatizado.

Protótipo em alta fidelidade feito no Figma

Tela anterior

Só é possível ver as perguntas da conta selecionada. A grande maioria das pessoas que utilizam a plataforma possui mais de uma conta no Mercado Livre, por isso, contratam, para fazer a gestão em um único lugar.

Aparece uma pergunta de cada vez mas o usuário não tem noção de quantas ele ainda precisa responder e nem pode filtrar.

Falta de hierarquia nas cores do botão gera confusão ao completar a ação.

Usuários gostam da estrutura da mensagem carregada de forma automática. Ele só precisa digitar o corpo da mensagem.

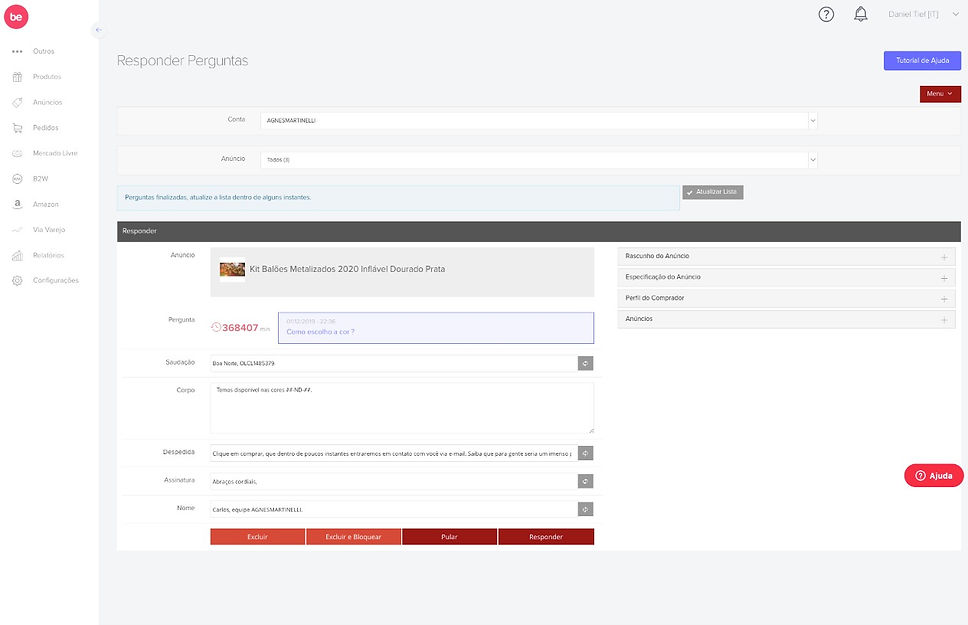

Tela Nova

2

3

1

5

4

6

7

7

7

10

1

Comecei pelo visual da tela, trazendo uma interface mais limpa e familiar, inspirada no estilo do WhatsApp Web — um aplicativo amplamente conhecido pelos usuários. Para tornar a experiência mais personalizada, incluí um avatar randômico para cada pessoa que envia uma pergunta, ajudando a humanizar a interação.

Pensei especialmente no operador que passa o dia inteiro realizando a mesma tarefa. Uma interface mais leve, com menos aparência de “sistema tradicional”, pode tornar a rotina mais agradável e reduzir a sensação de repetição.

2

A possibilidade de selecionar mais de uma conta foi um dos pedidos mais recorrentes durante a pesquisa, já que isso não era possível na versão anterior da tela. Agora, o usuário pode escolher responder por todas as contas ou apenas por contas específicas, o que facilita a organização e dá uma visão mais clara da carga de trabalho do dia.

6

O horário e a data da pergunta, assim como a identificação de quem respondeu, ficam registrados diretamente na interface. Um ponto interessante é que essa área também passou a funcionar como tela de histórico — diferentemente da versão anterior, em que era necessário acessar outra página para visualizar conversas com mais de uma pergunta e facilitar a resposta.

7

A plataforma oferece duas formas de responder às perguntas: manualmente ou de forma automática. A maioria dos usuários ainda prefere a resposta manual, por não se sentirem seguros em deixar o sistema responder sozinho com mensagens previamente cadastradas.

Para reduzir essa resistência, foi criado um botão que traz a resposta cadastrada automaticamente, mas exige que o usuário revise e confirme o envio. Essa abordagem ajuda a familiarizar o usuário com o modelo automatizado, transmitindo mais segurança e confiança no uso futuro da funcionalidade de resposta automática.

3

A pesquisa revelou que os usuários sentem falta de ter uma noção clara do volume de trabalho a ser feito — como quantas perguntas ainda precisam ser respondidas, quantas já foram resolvidas, além de poder aplicar filtros. A proposta é que essa lista tenha uma animação: à medida que o usuário responde, a pergunta é arquivada, gerando uma sensação visual de progresso, semelhante a uma To-do List.

8

A estrutura da resposta foi mantida conforme a preferência dos usuários — com saudação, despedida e assinatura já preenchidas, restando apenas inserir o corpo da mensagem. Para representar isso visualmente, utilizei um texto cinza dentro da caixa indicando essa estrutura e deixei o campo de resposta com o cursor piscando, sinalizando onde escrever.

Caso o usuário queira ajustar esse modelo fixo, é possível selecionar variações pelos botões posicionados acima da caixa de mensagem.

4

A pergunta em resposta permanece selecionada para garantir clareza no processo. Como identificado durante a pesquisa, algumas equipes são dedicadas exclusivamente a responder perguntas, por isso é fundamental que todos saibam quem está respondendo o quê em tempo real.

Na versão anterior da tela, isso não era possível — se dois operadores abrissem a mesma pergunta simultaneamente, o sistema apresentava falhas. Esse comportamento provavelmente estava relacionado a limitações tecnológicas da estrutura atual da plataforma.

9

Hierarquia dos botões: Posicionei o botão “Pular” antes do “Excluir”, já que é uma ação recorrente e frequentemente utilizada via teclado pelos operadores. Já o botão “Excluir” possui uma confirmação antes da ação, garantindo segurança contra exclusões acidentais. Além disso, essa função pode ser restrita conforme o nível de permissão que o dono da conta define para cada operador.

5

Este menu aciona a lateral direita da tela (já visível na imagem). A partir do mapeamento das perguntas mais frequentes recebidas pelos usuários e das informações que poderiam agilizar as respostas, foi desenvolvida essa barra lateral — uma ferramenta mais completa e acessível para apoiar o operador durante a tarefa.

10

Calcular frete, atalhos de teclado e respostas rápidas foram algumas das sugestões levantadas durante a pesquisa. Entre elas, o uso de atalhos merece destaque, especialmente pela redução de cliques — algo essencial considerando o grande volume de mensagens que os operadores precisam lidar. Como essa é uma tarefa que exige agilidade, qualquer ganho de tempo faz diferença no dia a dia.

Impacto e Resultados

Métricas:

-

Expectativa: redução de 60% no tempo de resposta manual.

-

100% das respostas manuais rastreáveis pela plataforma.

Próximos passos:

-

Expandir para múltiplas respostas por evento.

-

Incorporar sugestões da IA dentro da resposta manual.

Reflexão Final

Aprendizado como designer:

Aprendi que dar controle ao usuário, mesmo em sistemas automatizados, aumenta a confiança e reduz atrito.